Seit einigen Tagen habe ich mich mit dem Gedanken herumgeschlagen, eine Aktualisierung auf Windows 8.1 durchzuführen. Heute war dann die Zeit gekommen.

Windows 8.1 Upgrade – Tag 1 – Fehleranalyse

Oktober 27th, 2013Big Lazy Robot

Oktober 13th, 2013Per Zufall drüber gestolpert.

Planetary Annihilation

November 28th, 2012Es kommt mir wie gestern vor .. ich sitze mit meinem Bruder am Computer und schaue mir einen Trailer für das Spiel Supreme Commander an. Das war 2006 und von diesem Zeitpunkt an war ich begeistert für dieses Spiel. Als es dann im Februar 2007 erscheint, wird es gleich am ersten Tag gekauft. Noch heute spiele ich die Erweiterung „Forged Alliance“ recht häuftig. Supreme Commander war das erste Spiel, dass mich über einen so langen Zeitraum gefesselt hat.

Gestern bin ich dann mehr oder weniger zufällig über „Planetary Annihilation“ gestolpert, ein Spiel dessen Entwicklung erst vor kurzem gestartet ist und vermutlich noch ein paar Jahre in Anspruch nehmen wird. Aber schon der Trailers hat mich richtig fasziniert und ich wollte sofort losspielen. Leider geht das nicht 🙁

Man hatte das Spiel mit dem Ziel von 900,000 Dollar auf Kickstarter.com eingestellt und schlussendlich mit 2,2 Million ausreichend Zuspruch gefunden. Bei Planetary Annihilation sind wieder einige Leute an Board, die schon an Spielen wie Total Annihilation (1997) oder Supreme Commander (2007) mitgearbeitet haben. Ich bin sehr gespannt was für ein Spiel am Ende wirklich entstehen wird. Ich werde es weiter verfolgen…

Hier noch der Trailer von Supreme Commander von 2006, der mich damals wirklich zum Staunen gebracht hat.

Links

Planetary Annihilation – Offical Website

Planetary Annihilation on Kickstarter.com

Explorer’s unter Windows 8

August 30th, 2012Heute soll es mal um einige Änderungen des Windows-, Internet- und Spiele-Explorer in Windows 8 gehen.

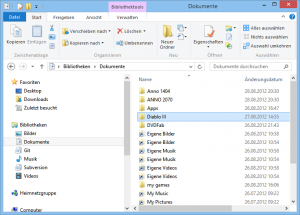

Der Windows Explorer

… wurde nun mit dem sogenannte Ribbon-Control versehen. Endlich, wie ich finde. Das wird zwar für viele eine große Umstellung bedeuten, meiner Meinung nach lohnt sich die Mühe jedoch, da man letzten Endes damit schneller und direkter arbeiten kann.

Im oberen Bereich ist das Ribbon zu sehen, das ich jedoch mittels Doppelklick (auf einen der Tabs z.B. Start) einklappe. Damit wird weniger Platz verschwendet. Über das Datei-Menü oben links kann man zu den häufig besuchten oder fest angepinnten Ordnern wechseln. Auch kann man hierüber im aktuellen Ordner die Eingabeaufforderung öffnen.

In der Titelleiste gibt es noch den sogenannten „Schnellzugriff“ (oben links). Dort kann man einige Befehl direkt erreichen, z.B. für das Erstellen eines neuen Ordners. Damit muss man trotz eingeklapptem Ribbon nicht unnötig Klicken, um einen Ordner anzulegen. (… oder man verwendet gleich Strg+Shift+N).

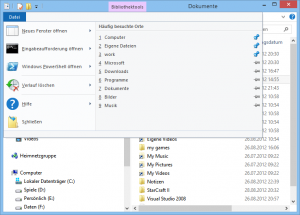

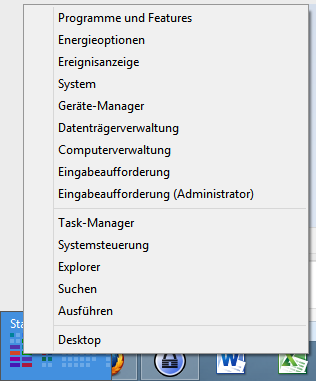

Das Win+X Menü

Microsoft hat mit Windows 8 das Startmenü in seiner herkömmlichen Version entfernt. Es gibt keinen Start-Button mehr links in der Taskleiste. Damit man aber trotzdem schnell auf gewisse System-Funktionen zugreifen kann, gibt es ein neues Menü. Wenn man die Maus in die untere linke Ecke bewegt, erscheint die Schaltfläche um mittels Klick in das neue Startmenü zu gelangen.

Wenn man nun hier aber die rechte Maustaste drückt, wird einem ein ganz spezielles Menü mit einigen wichtigen Systemfunktionen angeboten. Dieses Menü ist auch über die Tastenkombination Win+X erreichbar. Im Internet spricht man daher auch vom WinX-Menü.

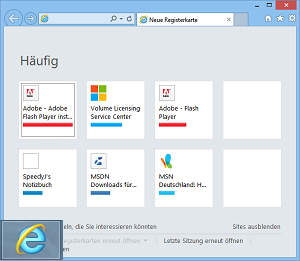

Der Internet-Explorer

… kommt eigentlich in zwei Darstellungs-Modi daher. Einmal der herkömmliche Desktop-Modus und der neue Modern-UI-Modus. Im neuen Startmenü erreicht man standardmäßig die Modern-UI-Variante anhand einer farblosen Kachel.

Und auf dem Desktop kann man über den angepinnten Internet-Explorer die herkömmliche Variante starten.

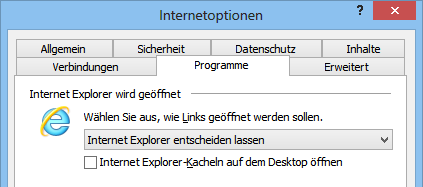

Doch wenn ich den an die Taskleiste (des Desktops) angepinnten Internet-Explorer entferne, kann ich dann aus dem neuen Startmenü die Desktop-Variante noch starten? Ja, das geht. Dafür hat man in den Internet Optionen eine extra Einstellung hinzugefügt.

Mit dem kleinen Häkchen kann man steuern, ob die IE-Kachel im Startmenü die Desktop-Version startet. Standardmäßig ist die Option deaktiviert, d.h. man startet die Modern-UI-Variante. Nachdem man den Haken gesetzt hat, öffnet sich der Internet-Explorer immer auf dem Desktop.

Übrigens, sobald man einen anderen Browser installiert und diesen als Standard-Browser definiert hat, wird die eben gezeigte Option in den Internetoptionen deaktiviert. Ab diesem Zeitpunkt kann man den Internet-Explorer nur noch in der Desktop-Version starten. Microsoft will hier anscheinend sicherstellen, dass man in der Modern-UI-Umgebung immer nur einen Browser nutzen kann.

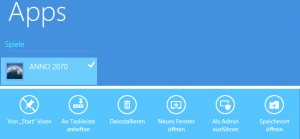

Der Spiele-Explorer

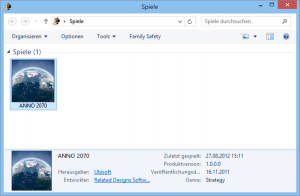

… wurde zu meiner Verwunderung aus Windows 8 entfernt. In einem entsprechenden Blog-Artikel hat Microsoft die Änderungen für Entwickler kurz umrissen und auch nochmal am 15.August.2012 für die Release-Version überarbeitet. Nach den dortigen Informationen soll der Spiele-Explorer nicht mehr sichtbar sein. Nunja, vielleicht nicht direkt. Aber man kann ihn noch immer anzeigen lassen. Das ist ja nur logisch, denn die Shell-Objekt-IDs muss es ja noch immer gehen. Wie das geht? Sobald man ein Spiel installiert hat, welches sich im Spiele-Explorer registriert, gibt es im Apps-Menü (Win+Q) einen Spiele-Bereich. Mit der rechten Maustaste kann man das Aktionsmenü öffnen. Dort wählt man „Speicherort öffnen“.

Wie man aber im Bild sieht, hat man hier nicht mal die notwendigen Übersetzungen mitgeliefert (was aber nicht wirklich ein Problem wäre).

Schade ist, dass andere Spiele (die man zum Beispiel über den Windows-Store installiert) hier nicht angezeigt werden. (Derartige — auf die Modern-UI ausgelegte Spiele — lassen sich auch nicht an die Desktop-Taskleiste anpinnen.) Damit ist das unbrauchbar. Eine zentrale Zugriffmöglichkeit auf alle installierten Spiele fällt damit einfach mal weg. Diesen Schritt verstehe ich nicht ganz und ich werde das Gefühl nicht los, dass man an dieser Stelle nicht fertig geworden ist.

Windows 8 nach zwei Wochen

Ehrlich gesagt habe ich mir die Umstellung schwieriger vorgestellt. Wer bereits mit Windows 7 arbeitet, kommt recht schnell mit Windows 8 zurecht. Wer jedoch von Windows XP wechselt, wird erstmal überfordert sein. Am Anfang habe ich hin und wieder gedacht, ich hätte keinen Grafiktreiber installiert, da die Fenster keine Transparenzeffekte aufweisen. Doch schon nach einer Woche hat man sich daran problemlos gewöhnt und vermisst es gar nicht mehr. Auf das neue Startmenü bin ich heute bewusst noch nicht weiter eingegangen. Auch die vorinstallierten Modern-UI-Apps muss ich noch genauer kennenlernen. Jedoch habe ich festgestellt, dass ich unter Windows 8 noch mehr Tastenkombinationen nutze als vorher. Sind diese Funktionen per Maus so umständlich zu erreichen, dass man lieber auf die Tastatur zurückgreift? Oder hat man einfach noch nicht die korrekt Handhabung raus? Das soll ein späterer Artikel zeigen.

Auf zu neuen Windows

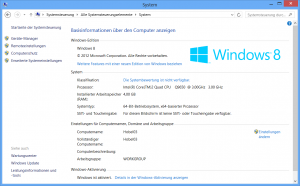

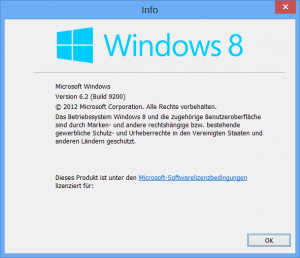

August 15th, 2012Seit heute (15. August 2012) ist Windows 8, Visual Studio 2012 und .NET Framework 4.5 für MSDN-Abonnenten verfügbar. Also war es Zeit mein parallel installiertes OpenSuse gegen Windows 8 zu tauschen.

Die Installation verlieft völlig problemlos. Ein wenig Erfahrung hatte ich bereits durch die Installation der Preview-Version in einer VM gesammelt. Wie wahrscheinlich die meisten Nutzer, habe ich eine Neuinstallation durchgeführt, um gleich einmal die Chance zu nutzen, alten Ballast loszuwerden. Die benötigten Anwendungen werde ich in den nächsten Tagen noch nachinstallieren. Auf den ersten Blick funktioniert alles wie gewohnt und man kann gleich loslegen. Natürlich ist vieles anders und noch gewöhnungsbedürftig. In der nächsten Zeit muss Windows 8 beweisen, dass man genauso schnell arbeiten kann wie unter Windows 7.

Wenn man so die Meinungen im Internet ließt, dann lehnen viele Leute schon vor der Veröffentlichung Windows 8 ab. Ich denke, früher oder später wird man damit in Berührung kommen, und wenn man sich damit auseinandersetzt, dann kann man sich selbst ein Bild davon machen.

Von meinem Bild werde ich hier weiterhin berichten.